Задачи на формулу шеннона – научиться решать задачи на определение количества информации по формулам Хартли и Шеннона. Тема. Формула Шеннона. Формула Хартли.”. Скачать бесплатно и без регистрации.

- Комментариев к записи Задачи на формулу шеннона – научиться решать задачи на определение количества информации по формулам Хартли и Шеннона. Тема. Формула Шеннона. Формула Хартли.”. Скачать бесплатно и без регистрации. нет

- Советы абитуриенту

- Вероятностный подход к определению количества информации. Формула Шеннона. Решение задач

- Количество информации в сообщении о неравновероятных событиях. Формула Шеннона.

- Небольшая подборка материалов на тему “Формула Шеннона” (10 класс, профиль)

- Вероятностный подход к оценке количества информации. Формула Шеннона

- Формулы Хартли и Шеннона Вероятностный подход к измерению количества информации

- Формулы Хартли и Шеннона

- Вероятностный подход к измерению количества информации

- Терехова Н.А.

- 1928 год американский инженер Хартли процесс получения информации рассматривает как выбор одного сообщения из конечного заданного множества N равновероятных событий

- Формула Хартли: I=log2N где I -количество информации, N -число равновероятных событий.

- Задача: Какое количество информации требуется, чтобы угадать одно число из 128? Решение: I=log2128=7 бит

- Задача: Какое количество информации требуется, чтобы угадать одно число из 100? Решение: I=log2100≈6,644 бит

- Вывод: с увеличением числа вероятных событий (N), увеличивается количество информации (I), полученной при совершении одного из событий.

- Формула Хартли может быть записана и так: N=2I Если N=2 (выбор из двух возможностей), то I=1 бит.

- Так как наступление каждого из N событий имеет одинаковую вероятность P, то Р=1/N. Если событий 6, то вероятность появления одного события равно 1/6, если событий 100, то вероятность равна 0,01 => N=1/P

- Формулу Хартли можно записать иначе: I=log2(1/P)= log2P-1= – log2P так как p0

- Примеры равновероятных сообщений: 1) при бросании монеты выпала «решка», выпал «орел» 2) на странице книги количество букв четное, нечетное.

- Задача: Определить, является ли равновероятным событие – из дверей выйдет первым мужчина или женщина?

- 1948 год американский ученый Клод Шеннон предложил другую формулу определения количества информации, учитывая возможную неодинаковую вероятность событий в наборе.

- Формула Шеннона: I=-(p 1 log 2p 1+ p 2 log 2p 2 + p 3 log 2p 3 +…. p N log 2p N ), где p I вероятность того, что именно I –е сообщение выделено в наборе из N сообщений.

- Другая запись формулы Шеннона: I=-

- Задача. Пусть имеется строка текста, содержащая 1000 букв. Буквы встречаются в тексте: «о»-90 раз «р» -40 раз «Ф»- 2 раза «а»-200 раз. Какое количество информации несет буква в строке?

- Решение: I=-(0,09*log 2 0,09 + 0,04* log 2 0,04 + 0,002* log 2 0,002 + 0,2* log 2 0,2)=

- Формула Шеннона

- Вероятностный подход к измерению информации. Формула Шеннона моу «Февральская средняя общеобразовательная школа №1»

- Вероятностный подход к измерению информации. Формула Шеннона

- МОУ «Февральская средняя общеобразовательная школа № 1»

- Учитель информатики: Т.А. Батукова

- Вероятностный подход

- Равновероятные события

- Формула Шеннона

- I – количество информации;

- N – количество возможных событий;

- рi – вероятность i-го события (р = К/N, К – величина, показывающая, сколько раз произошло интересующее нас событие).

- Формула Шеннона

- Вероятностный подход

- Количественная зависимость между вероятностью события (р) и количеством информации в сообщении о нем (i) выражается формулой:

- Задача

- В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков.

- Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика?

- Решение

- рб = 10/100 = 0,1;

- рк = 20/100 = 0,2;

- рс = 30/100 = 0,3;

- рз = 40/100 = 0,4.

- Задача

- В коробке имеется 50 шаров. Из них 40 белых и 10 черных. Определите количество информации в сообщении о том, что при вытаскивании «не глядя» попадется белый шар, черный шар.

- Решение

- Обозначим рч – вероятность попадания черного шара, рб – вероятность попадания белого шара.

- рч = 40/50 = 0,8;

- рб = 10/50 = 0,2;

- Iб = log2(1/0,2) ≈ 2,32;

- iч = log2(1/0,8) ≈ 0,32

- Вероятностный подход

- Чем меньше вероятность некоторого события,

- тем больше информации содержит сообщение об этом событии.

- Задача

- В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Сколько информации мы получим, когда поймаем какую – нибудь рыбу?

- Решение

- Найдем общее количество рыб в озере: К = 12500 + 25000 + 2.6250 = 50000.

- Найдем вероятность попадания на удочку каждого вида рыб:

- Ро = 12500/50000 = 0,25

- Рк = 25000/50000 = 0,5

- Pп = 6250/50000 = 0,125

- Pщ = 6250/50000 = 0,125

- Найдем количество информации

- I = – (0,25.log20,25 + 0,5.log20,5 + 0,125.log20,125 + 0,125.log20,125) бит ≈ 1,75 бита

- Задача 2

- В корзине лежат 8 черных шаров и 24 белых. Сколько информации несет сообщение о том, что достали черный шар?

- Решение

- N = 8 + 24 = 32 – шара всего

- Рч = 8/32 = ¼ – вероятность доставания черного шара

- I = log2 (1/¼) = 2 бита.

- Домашнее задание

- Дополнительная задача

- В пруду живут 8000 карасей, 2000 щук и 40000 пескарей. Определите количество информации при попадании на удочку каждого из видов рыб.

- Использованные источники:

- Информатика. Задачник-практикум в 2 т. /Под ред.И.Г. Семакина, Е.К. Хеннера: Том 1. – М.: БИНОМ. Лаборатория знаний, 2004.

- Соколова О.Л. Универсальные поурочные разработки по информатике. 10 класс. – М., ВАКО, 2006.

- Угринович Н. Д. Информатика и информационные технологии. Учебник для 10-11 классов, – М., БИНОМ. Лаборатория знаний. 2007.

- Угринович Н. Д. Преподавание курса «Информатика и ИКТ» в основной и старшей школе. 7-11: Методическое пособие. – М., БИНОМ. Лаборатория знаний. 2007.

- Угринович Н.Д. Практикум по информатике и информационным технологиям.Учебное пособие для общеобразовательных учреждений. Изд. 2-е, испр./ Н.Д. Угринович, Л.Л. Босова, Н.И. Михайлова – М.:БИНОМ. Лаборатория знаний, 2004

- CD «Компьютерный практикум Windows-CD». Приложение к пособию Угринович Н. Д. Преподавание курса «Информатика и ИКТ» в основной и старшей школе. 7-11: Методическое пособие. – М., БИНОМ. Лаборатория знаний. 2007.

- http://ru.wikipedia.org/wiki/%D0%A8%D0%B5%D0%BD%D0%BD%D0%BE%D0%BD_%D0%9A.

Вероятностный подход к определению количества информации. Формула Шеннона. Решение задач

Цель урока:

1. Ввести формулу Шеннона для не равновероятных событий.

Ход уроков:

1. Организационный момент – сбор ИДЗ, объявление темы и целей урока – 5 мин;

2. Актуализация знаний учащихся – 10 мин;

3. Объяснение нового материала – 10 мин;

4. Решение задач – (20+25) мин;

5. Постановка домашнего задания – 3 мин;

6. Подведение итогов урока – 17 мин.

Актуализация знаний учащихся

На этом этапе предлагается обсудить (проверить владение материалом) следующие вопросы, а также поставить учащихся перед затруднением (задание 5, 6):

1. Приведите примеры равновероятных (В коробке 12 карандашей разного цвета) и неравновероятных (На ферме 12 цыплят, 7 кур, 1 петух и 5 гусей) событий?

2. Как определить вероятность выполнения определенного события? (Нужно количество событий определенного типа разделить на общее количество событий.)

3. Запишите (на доске) определение и два свойства логарифмов.

(Опр-е: ,

Свойства: 1) ,

2) .)

4. На ферме живут 16 цыплят, 7 кур, 1 петух и 5 гусей. Определить количество информации в зрительном сообщении: «На рождество зажарили цыпленка». (I=4 бита)

5. Мама попросила дочку сходить в магазин и купить фрукты. В магазине в наличии было 4 кг. яблок, 5 кг. груш и 10 кг. апельсинов. Определить количество информации, полученной мамой в зрительном сообщении о покупке, сделанной дочкой.

Объяснение нового материала

В задаче 5 не конкретизировано, какие фрукты купила дочка. Информацией для мамы будет именно вид фруктов.

В 1948 году К. Шеннон предложил формулу для вычисления количества информации для неравновероятных событий в общем случае: , где I – количество информации, которое мы получим после реализации одного из возможных событий; N – количество видов возможных событий; Рi- вероятность i–го события.

Решим задачу 5.

Количество видов событий: N показывает сколько будет слагаемых. Речь идет о яблоках, грушах и апельсинах, поэтому N=3.

Определим вероятности покупки каждого вида фруктов: .

Тогда количество информации, которое получит мама после прихода дочки домой, можно рассчитать по формуле Шеннона:

Бита.

Решение задач (Тексты задач перед учащимися имеются, поэтому существует возможность для самостоятельного решения – 27 мин).

Задача №10. Вероятность первого события составляет 0,5, а второго и третьего — 0,25. Какое количество информации мы получим после реализации одного из них?

Решение.

Р1=0,5; Р2=Р3=0,25 Þ Бита.

Ответ: 1,5 бита.

Задача №11. За контрольную работу по информатике получено 8 пятерок, 13 четверок, 6 троек и 2 двойки. Какое количество информации получил Васечкин при получении тетради с оценкой?

Решение.

Краткая запись условия | Решение |

К5=8 К4=13 К3=6 К2=2 | Основная формула: , рк=. , , , Подставляем полученные вероятности: |

I – ? |

Ответ: 1,77 бита.

Задача №12. Известно, что в ящике лежат 20 шаров. Из них 10 — черных, 4 — белых, 4 — желтых и 2 — красный. Какое количество информации несёт сообщения о цвете вынутого шара?

Задача №13. Добрый экзаменатор никогда не ставит двоек по информатике. По причине своей доброты он заранее определил количество отметок каждого вида и произвольно расставил их абитуриентам. Количество информации, содержащееся в сообщении “Абитуриент Иванов не сдал экзамен на отлично”, равно 3-log27 бит. Информационный объем сообщения “Абитуриент Сидоров получил четверку” равен двум битам. Определите информационный объем зрительного сообщения о полученной оценки абитуриентом Сидоровым.

Решение. Из условия видно, что количество оценок, распределенных экзаменатором различное и вопрос задачи указывает на одну из всех возможных оценок, поэтому воспользуемся подходом к определению количества информации для неравновероятных событий, а именно формулой Шеннона.

Обозначим i4 – количество информации в сообщении “Абитуриент Сидоров получил четверку”, i4или3 – количество информации в сообщении “Абитуриент Иванов не сдал экзамен на отлично”, I – информационный объем зрительного сообщения о полученной оценки абитуриентом Сидоровым, К – показатель определенной оценки, р3, р4, р5 – вероятности выставления троек, четверок и пятерок соответственно, р4или3 – вероятность выставления оценки не отлично

Краткая запись условия | Решение |

I4или3=3-log27 бита I4=2 бита | Основные формулы: ,, Рк=, (*). Найдем вероятности р5 и р4: 3-log27=ÞÞ Þ, Аналогично Þ. Подставляем полученные вероятности в формулу (*) |

I – ? |

Ответ: 1,3 бита.

Задача №14. У скупого рыцаря в сундуке золотые, серебряные и медные монеты. Каждый вечер он извлекает из сундука одну из монет, любуется ею, и кладет обратно в сундук. Информационный объем сообщения “Из сундука извлечена золотая монета” равен трем битам. Количество информации, содержащееся в сообщении “Из сундука извлечена серебряная монета”, равно двум битам. Определите информационный объем зрительного сообщения о достоинстве вынутой монеты.

Задача №15. В сейфе банкира Богатеева лежат банкноты достоинством 1, 10 или 100 талеров каждая. Банкир раскрыл свой сейф и наугад вытащил из него одну банкноту. Информационный объем сообщения “Из сейфа взята банкнота достоинством в 10 талеров” равен 3 бита. Количество информации, содержащееся в сообщении “Из сейфа взята банкнота достоинством не в 100 талеров”, равно 3-log25 бит. Определите информационный объем зрительного сообщения о достоинстве вынутой банкноты.

Домашнее задание (На этом этапе выдается задание на дом с пояснением его выполнения – 3 мин).

1. Выучить теорию – § 2.4 [8];

2. Решить задачи №123 (уровень оценки «3»), №124 (уровень оценки «4») и № 127, №128 (уровень оценки «5») [2].

3. Подготовиться к контрольной работе (повторить §2.1-2.4 [8]).

Подведение итогов урока – на этом этапе полезно:

I. Вывод:

Как найти количество информации при совершении не равновероятных событий в общем и частном случаях? (Частный случай – формула Хартли – , общий случай – формула Шеннона – )

II. Самостоятельная работа (учащимся предлагается самостоятельно (без решения у доски) испробовать свои силы в различении подходов к определению информации и применению соответствующей формулы – 10 мин).

www.testsoch.com

Количество информации в сообщении о неравновероятных событиях. Формула Шеннона.

Автор: Лузгина Наталия Геннадьевна, учитель информатики I кв.категории МБОУ «СОШ №11» г.Балахна Нижегородской обл.

Урок на тему «Количество информации в сообщении о неравновероятном событии.

Формула Шеннона».

(10 класс, профильный уровень, по учебнику Н.Д.Угриновича)

Цель урока:

Ввести формулу для определения количества информации для неравновероятных событий.

Задачи:

образовательная: познакомить учащихся с формулой для вычисления количества информации в сообщении о неравновероятном событии, формулой Шеннона; определить качественную связь между вероятностью события и количеством информации в сообщении об этом событии; научить решать задачи с использованием формулы Шеннона.

развивающая: способствовать развитию логического мышления (умения сравнивать, делать выводы), познавательной активности.

воспитывающая: прививать навыки самостоятельной работы, работы в парах; воспитывать умение высказывать личное мнение и прислушиваться к мнению других.

Используемые технологии: проблемного обучения.

Оборудование: интерактивная доска, проектор, презентация к уроку.

Ход урока

I. Постановка цели урока.

СЛАЙД 1. Учащимся предлагается устно решить задачу:

Задача: Какое сообщение содержит большее количество информации?

В библиотеке 8 шкафов. Книга нашлась в 3-м шкафу; (Отв.: 3 бит.)

Вася получил за экзамен оценку 4 (по 5-бальной системе единицы не ставят). (

Бабушка испекла 12 пирожков с капустой, 12 пирожков с повидлом. Маша съела один пирожок. (Отв.: 1 бит.)

Бабушка испекла 8 пирожков с капустой, 24 пирожка с повидлом. Маша съела один пирожок.

(В четвертом варианте учащиеся сталкиваются с ситуацией, когда события не равновероятны).

Действительно, далеко не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или “правило бутерброда”.

СЛАЙД 2. Как вы думаете, какова же тема сегодняшнего урока? А цель?( исходя из выше обозначенной проблемы учащиеся сами формулируют тему и цель урока)

Ребята, вы абсолютно правы, сегодня на уроке мы должны ответить на вопрос: как вычислить количество информации в сообщении о неравновероятном событии.

II. Объяснение нового материала.

СЛАЙД 3. Для вычисления количества информации в сообщении о неравновероятном событии используют следующую формулу:

I=log2(1/p), где

I – это количество информации,

р – вероятность события.

Вероятность события выражается в долях единицы и вычисляется по формуле:

р=K/N, где

К – величина, показывающая сколько раз произошло интересующее нас событие,

N – общее число возможных исходов какого-то процесса.

СЛАЙД 4. Вернемся к нашей задаче.

Пусть:

К1 – это количество пирожков с повидлом, К1=24

К2 – количество пирожков с капустой, К

N – общее количество пирожков, N = К1 +К2, N=24+8=32

Вычислим вероятность выбора пирожка с разной начинкой и количество информации, которое при этом было получено.

Вероятность выбора пирожка с повидлом: р1=24/32=3/4=0,75.

Вероятность выбора пирожка с капустой: р2=8/32=1/4=0,25.

Обращаем внимание учащихся на то, что в сумме все вероятности дают 1.

Вычислим количество информации, содержащееся в сообщении, что Маша выбрала пирожок с повидлом:

I1=log2(1/p1), I1= log2(1/0,75)= log21,3=1,15470 бит.

Вычислим количество информации, содержащееся в сообщении, если был выбран пирожок с капустой:

I2=log2(1/p2), I2= log2(1/0,25)= log24=2 бит.

При сравнении результатов вычислений получается следующая ситуация:

вероятность выбора пирожка с повидлом больше, чем с капустой, а информации при этом получилось меньше. Это не случайность, а закономерность.

Качественную связь между вероятностью события и количеством информации в сообщении об этом событии можно выразить так: чем меньше вероятность некоторого события, тем больше информации содержит сообщение об этом событии.

Вернемся к нашей задаче с пирожками. Мы еще не ответили на вопрос: сколько получим информации при выборе пирожка любого вида?

СЛАЙД 5. Ответить на этот вопрос нам поможет формула вычисления количества информации для событий с различными вероятностями, которую предложил в 1948 г. американский инженер и математик Клод Элвуд Шеннон.

Если I-количество информации,

N-количество возможных событий,

рi – вероятности отдельных событий, где i принимает значения от 1 до N, то количество информации для событий с различными вероятностями можно определить по формуле:

СЛАЙД 6. можно расписать формулу в таком виде:

Знак минус в формуле не означает, что количество информации в сообщении – отрицательная величина. Объясняется это тем, что вероятность (р), согласно определению, 0. Т.к. Log числа, меньшего 1 (т.е. log pi) – величина отрицательная, то произведение вероятности на логарифм числа будет положительным.

Рассмотрим формулу на нашем примере:

I = – (р1∙log2p1 + р2∙log2p2),

I= – (0,25∙ log20,25+0,75∙ log20,75)≈-(0,25∙(-2)+0,75∙(-0,42))=0,815 бит

СЛАЙД 7. Теперь ответьте на вопрос задачи, которая была поставлена в начале урока: Какое сообщение содержит большее количество информации?

В библиотеке 8 шкафов. Книга нашлась в 3-м шкафу; (Отв.: 3 бит.)

Вася получил за экзамен 3 балла (по 5-бальной системе единицы не ставят). (Отв.: 2 бит.)

Бабушка испекла 12 пирожков с капустой, 12 пирожков с повидлом. Маша съела один пирожок. (Отв.: 1 бит.)

Бабушка испекла 8 пирожков с капустой, 24 пирожка с повидлом. Маша съела один пирожок. (Отв.: 0,815 бит.)

Ответ: в 1 сообщении.

Обратите внимание на 3 и 4 задачу. Сравните количество информации.

Мы видим, что количество информации достигает максимального значения, если события равновероятны.

Можно ли применить формулу К. Шеннона для равновероятных событий?

Если p1=p2=..=pn=1/N, тогда формула принимает вид:

Мы видим, что формула Хартли является частным случаем формулы Шеннона.

III. Закрепление изучаемого материала.

СЛАЙД 8.

Задача №1: (объясняет учитель)

В корзине лежат 32 клубка красной и черной шерсти. Среди них 4 клубка красной шерсти.

Сколько информации несет сообщение, что достали клубок красной шерсти? Сколько информации несет сообщение, что достали клубок шерсти любой окраски?

Дано: Кк=4;N=32

Найти: Iк, I

Решение:

Найдем количество клубков черной шерсти:

Кч=N- Кк; Кч=32-4=28

Найдем вероятность доставания клубка каждого вида:

pк= Кк/N, pк =4/32=1/8;

pч= Кч/N, pч =28/32=7/8;

Найдем количество информации, которое несет сообщение, что достали клубок красной шерсти:

Iк= log2(1/(1/ pк)), Iк = log2(1/1/8)= log28=3 бита

Найдем количество информации, которое несет сообщение, что достали клубок шерсти любой окраски:

Ответ: Iк=3 бит; I=0,547 бит

(Задачи 2-4 учащиеся решают в парах с дальнейшей защитой решения у доски).

Задача №2: В непрозрачном мешочке хранятся 10 белых, 20 красных, 30 синих и 40 зеленых шариков. Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика?

Задача №3: В озере обитает 12500 окуней, 25000 пескарей, а карасей и щук по 6250. Какое количество информации несет сообщение о ловле рыбы каждого вида. Сколько информации мы получим, когда поймаем какую-нибудь рыбу?

Задача №4: В коробке лежат кубики: 10 красных, 8 зеленых, 5 желтых, 12 синих. Вычислите вероятность доставания кубика каждого цвета и количество информации, которое при этом будет получено.

VI. Подведение итогов урока.

СЛАЙД 9. Ответьте на вопросы:

Объясните на конкретных примерах отличие равновероятного события от неравновероятного?

С помощью какой формулы вычисляется вероятность события?

Объясните качественную связь между вероятностью события и количеством информации в сообщении об этом событии?

В каких случаях применяется формула Шеннона для измерения количества информации?

В каком случае количество информации о событии достигает максимального значения?

V. Домашнее задание.

СЛАЙД 10. §2.4 стр.111-113. Устно №2.3 стр.114-115. Письменно №2.3 стр.115

ИСТОЧНИКИ:

Н.Д.Угринович «Информатика и ИКТ». Учебник для10 класса, профильный уровень.

http://marknet.narod.ru/spr/list5.htm Информатика. Справочный материал. Количество информации. Формулы Хартли и Шеннона

Н.Д.Угринович, методическое пособие «Информатика и ИКТ 8 -11 класс»

kopilkaurokov.ru

Небольшая подборка материалов на тему “Формула Шеннона” (10 класс, профиль)

Самостоятельная работа ______________________________(Фамилия)

В-1.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10011001

10234

1764

1АВ1

Решить задачу в ЭТ и заполнить таблицу:

Мама раздала детям разные фрукты: яблоки, груши, апельсины, мандарины, киви. Известно, что яблок было 15, мандаринов – 10, груш – 20, апельсинов – 10, а киви – 6 штук. Сколько информации содержит сообщение о том, что кто-то получил яблоко? Сколько информации содержится в сообщении о том, что ребенок получил какой-то фрукт? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа______________________________(Фамилия)

В-2.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10101001

11034

1591

А1В1

Решить задачу в ЭТ и заполнить таблицу:

Учитель проводит контрольную работу по вариантам, разделенным по сложности: 1, 2 – простые, 3 – средней сложности, 4,5 – сложные. Известно, что карточек с 1 вариантом было 7, со вторым – 10, с третьим – 8, с четвертым – 5, а с пятым – 2 штуки. Сколько информации содержит сообщение о том, что кто-то получил 2 вариант? Сколько информации содержится в сообщении о том, что ученик получил какой-то вариант? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа ______________________________(Фамилия)

В-3.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10111101

12304

2049

ААВ9

Решить задачу в ЭТ и заполнить таблицу:

В олимпиаде по химии принимают участие дети из 5 учебных заведений: школа № 1, школа № 3, школа № 5, школа № 7, школа № 9. Известно, что учеников из школы № 1 было 5, из школы № 3 – 2, из школы № 7 – 3, из школы № 5 – 1, а из школы № 9 – 6 человек. Сколько информации содержит сообщение о том, что выиграл ученик из школы № 9? Сколько информации содержится в сообщении о том, что кто-то выиграл олимпиаду? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Самостоятельная работа______________________________(Фамилия)

В-4.

Заполнить таблицу (вычисления обязательны)

Двоичная

Пятеричная

Десятеричная

Двенадцатеричная

10101111

12234

2047

АВАВ

Решить задачу в ЭТ и заполнить таблицу:

В аквариуме плавает пять видов рыб: скалярии, барбусы, гурами, гуппи и неоны. Известно, что барбусов 7 рыб, скалярий – 2, гурами – 4, гуппи – 15, а неонов – 10 штук. Сколько информации содержит сообщение о том, что заболел один из гуппи? Сколько информации содержится в сообщении о том, что заболела одна рыбка? Ответы дать с точностью до двух знаков после запятой.

Событие

Кол-во, шт.

Вероятность события

Информация о событии

Вероятность события вообще

Ответы к заданиям самостоятельной работы.

В-4

2

5

10

12

10101111

1200

175

127

1110110000

12234

944

668

11111111111

31142

2047

1227

100101000110011

1101440

18995

АВАВ

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Скалярии

2

0,05

4,25

0,22

Гурами

4

0,11

3,25

0,34

Гуппи

15

0,39

1,34

0,53

Неоны

10

0,26

1,93

0,51

Барбусы

7

0,18

2,44

0,45

38

1,00

2,05

В-3

2

5

10

12

10111101

1224

189

139

1110111010

12304

954

676

100000000001

31144

2049

1229

100100110101101

1100421

18861

ААВ9

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Школа 1

5

0,29

1,77

0,52

Школа 3

2

0,12

3,09

0,36

Школа 5

1

0,06

4,09

0,24

Школа 7

3

0,18

2,50

0,44

Школа 9

6

0,35

1,50

0,53

17

1,00

2,09

В-2

2

5

10

12

10101001

1134

169

121

1100000001

11034

769

541

11000110111

22331

1591

В07

100010010010101

1030212

17557

А1В1

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

1

7

0,22

2,19

0,48

2

10

0,31

1,68

0,52

3

8

0,25

2,00

0,50

4

5

0,16

2,68

0,42

5

2

0,06

4,00

0,25

32

1,00

2,17

В-1

2

5

10

12

10011001

1103

153

109

1010110110

10234

694

49А

11011100100

24024

1764

1030

110011100101

101201

3301

1АВ1

Событие

Кол-во

Вероятность

Информ о событ

Компон Шеннон

Груши

20

0,33

1,61

0,53

Яблоки

15

0,25

2,02

0,50

Апельсины

10

0,16

2,61

0,43

Мандарины

10

0,16

2,61

0,43

Киви

6

0,10

3,35

0,33

61

1,00

2,21

infourok.ru

Вероятностный подход к оценке количества информации. Формула Шеннона

В основе нашего мира лежат три составляющие: вещество, энергия и информация. Как много в мире вещества, энергии и информации? Можно ли их измерить и как именно? Нам известны способы измерения количества вещества и энергии. Но как быть с информацией? Можно ли ее измерить?

Ранее уже отмечалось, что существует несколько подходов к оценке количества информации. Сейчас мы более подробно остановимся на одном из них.

Любое сообщение будет являться информативным, если оно пополняет знания человека, т.е. уменьшает неопределенность его знаний.

Равновероятные события

Пример 1

Например, при подбрасывании монеты мы пытаемся угадать, какой стороной она упадет. Возможен один из вариантов исхода: монета окажется в положении «орел» или «решка». Каждое из этих двух событий окажется равновероятным, т. е. ни одно из них не имеет преимущества перед другим. Перед подбрасыванием монеты никто не может знать, как она упадет, т.е. существует неопределенность знания. После же наступления события, наоборот, присутствует полная определенность, так как бросающий получает зрительное сообщение о положении монеты, которое, в свою очередь, уменьшает неопределенность его знания в два раза, поскольку из двух равновероятных событий произошло одно.

Пример 2

Другим примером является ситуация с шестигранным кубиком, т.е. перед броском никто не может знать, какой стороной он упадет. В данном случае присутствует возможность получить один результат из шести равновероятных. Таким образом, до броска неопределенность знаний бросающего будет равна 6, после же броска, она уменьшится ровно в 6 раз, поскольку именно 6 равновероятных событий может произойти.

Пример 3

Рассмотрим пример, где для экзамена приготовили 40 билетов. Вероятность событий, которые произойдут при вытягивании билета, будет равна 40. Причем эти события будут равновероятны. При этом неопределенность знаний студента перед выбором билета, будет равна 40. Соответственно неопределенность знания после того как студент взял билет уменьшится в 40 раз. Зададимся вопросом, зависит ли этот показатель от номера вытянутого билета. Нет, поскольку события равновероятны.

Проанализировав все рассмотренные выше примеры, можно прийти к выводу, что чем больше исходное число возможных равновероятных событий, тем в большее количество раз уменьшается неопределенность знаний, и тем большее количество информации будет содержаться в сообщении о результатах опыта.

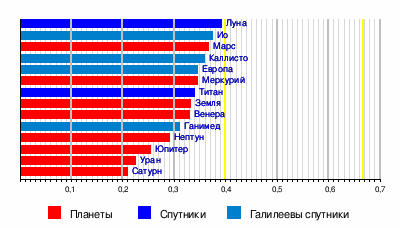

Неравновероятные события

Рассмотрим в качестве примера разговорные языки. Обратимся к фактам доказанных исследований, которые показывают, что во всех разговорных языках одни буквы встречаются гораздо чаще, чем другие. Результаты исследований подтверждают, что на $1000$ букв в разных разговорных языках приходится различное число повторений. В качестве примеров в таблице приведены некоторые буквы в русском и английском языках:

Рисунок 1.

Помимо этого, вероятность появления отдельных букв будет зависеть от того, какие буквы используются перед ними. Так, в русском языке после гласной никогда не может стоять мягкий знак, а также в словах не используются четыре гласные подряд и т.д. Разговорные языки имеют, как правило, свои особенности и закономерности. Именно поэтому количество информации, содержащееся в сообщениях любого разговорного языка, неприемлемо оценивать с помощью формулы Хартли, которая используется в алфавитном подходе к оценке информации и характерна для примеров с равновероятными событиями (примеры с монетой и кубиком).

Как определить, какое количество информации содержит, например, текст романа “Война и мир”, или фрески и полотна великих итальянских художников, или генетический код человека? Ответы на эти вопросы и подобные им науке пока не известны и, по всей вероятности, еще не скоро будут известны. Однако всех интересует, возможно ли объективно оценить количество информации? К задаче подобного рода можно отнести следующий пример.

Как выяснить, являются ли равновероятными сообщения “первой выйдет из здания женщина” и “первым выйдет из здания мужчина”? Однозначного ответа на этот вопрос нет. Все будет зависеть от того, о каком именно здании идет речь. Если это, например, здание гинекологической клиники, то вероятность выйти первой у женщины очень высока, если это военная казарма, то вероятность выйти первым для мужчины будет выше, чем для женщины, а вот если это здание кинотеатра, то вероятности выйти первыми для мужчины и женщины будут одинаковыми.

Оценка количества информации. Формула Шеннона

Для решения задач подобного рода используется общая оценка количества информации, предложенная американским учёным Клодом Шенноном в 1948г. Созданная им формула определения количества информации способна учитывать возможную неодинаковую вероятность сообщений, содержащихся в наборе. Шеннон при создании формулы использовал применяемую в математике и гидродинамике вероятностную меру неопределенности (называемую энтропией) для того, чтобы в полной мере оценить состояние изучаемой системы и получить максимально возможную информацию о протекающих в этой системе процессах. Эта оценка количества информации, по существу, является вероятностной мерой, и, как оценка неопределенности, она отражает способность какого-либо источника проявлять все новые и новые состояния и таким образом отдавать информацию.

Определение 1

Шеннон определил энтропию как среднюю логарифмическую функцию множества вероятностей возможных состояний системы (возможных исходов опыта). Для расчета энтропии Шеннон предложил следующее уравнение:

$H= -( p_1log_2p_1+p_2log_2p_2+. . .+p_Nlog_2p_N)$,

где $p_i$ – вероятность появления $i$-того события в наборе из $N$ событий.

Тогда количество информации, полученное в результате опыта, будет не что иное, как разность между энтропией системы до ($H_0$) и после ($H_1$) опыта:

$I=H_0-H_1$,

причем если неопределенность в результате опыта полностью исключается, то имеем:

$I= -H_1$

$I=\Sigma (p_ilog_2p_i), i=1,\dots ,N$.

Рассмотрим пример, подтверждающий использование данной теории Шеннона на практике.

Пример 4

В озере обитают пескари и окуни. Подсчитано количество особей в каждой популяции (пескарей – $1500$, а окуней – $500$). Необходимо определить, сколько информации содержится в сообщениях о том, что рыбак выловил пескаря, окуня, вообще рыбу?

Решение. События улова пескаря или окуня не являются равновероятными, поскольку окуней в озере обитает намного меньше, чем пескарей.

Общее количество пескарей и окуней, обитающих в озере:

$1500 + 500 = 2000$.

Определим вероятность улова пескаря:

$p_1= \frac{1500}{2000} = 0,75$,

Определим вероятность улова окуня:

$p_2 – \frac{500}{2000} = 0,25$.

$I_1=log_2(\frac{1}{p_1}), I_1=log_2(\frac{1}{p_2})$,

где $I_1$ и $I_2$ – вероятности улова пескаря и окуня соответственно.

Количество информации, содержащейся в сообщении об улове пескаря:

$I_1 = log_2(\frac{1}{0,75}) » 0,43$ бит,

Количество информации, содержащейся в сообщении об улове окуня:

$I_2=log_2(\frac{1}{0,25}) » 2$ бит.

Количество информации, содержащейся в сообщении об улове рыбы (карася или окуня) рассчитывается по формуле Шеннона:

$I = – p_1log_2p_1 – p_2log_2p_2$

$I = -0,75 \cdot log_20,75- 0,25 \cdot log_20,25=-0,75 \cdot (\frac{log0,75}{log2})-0,25 \cdot(\frac{log0,25}{log2}) =0,604 бит » 0.6$ бит.

Ответ: в сообщении содержится $0,6$ бит информации

spravochnick.ru

Формулы Хартли и Шеннона

1928 год американский инженер Хартли процесс получения информации рассматривает как выбор одного сообщения из конечного заданного множества N равновероятных событийФормула Хартли: I=log2N где I -количество информации, N -число равновероятных событий.Задача: Какое количество информации требуется, чтобы угадать одно число из 128? Решение: I=log2128=7 битЗадача: Какое количество информации требуется, чтобы угадать одно число из 100? Решение: I=log2100≈6,644 битВывод: с увеличением числа вероятных событий (N), увеличивается количество информации (I), полученной при совершении одного из событий.Формула Хартли может быть записана и так: N=2I Если N=2 (выбор из двух возможностей), то I=1 бит.Так как наступление каждого из N событий имеет одинаковую вероятность P, то Р=1/N. Если событий 6, то вероятность появления одного события равно 1/6, если событий 100, то вероятность равна 0,01 => N=1/PФормулу Хартли можно записать иначе: I=log2(1/P)= log2P-1= – log2P так как p0Примеры равновероятных сообщений: 1) при бросании монеты выпала «решка», выпал «орел» 2) на странице книги количество букв четное, нечетное.Задача: Определить, является ли равновероятным событие – из дверей выйдет первым мужчина или женщина?1948 год американский ученый Клод Шеннон предложил другую формулу определения количества информации, учитывая возможную неодинаковую вероятность событий в наборе.Формула Шеннона: I=-(p 1 log 2p 1+ p 2 log 2p 2 + p 3 log 2p 3 +…. p N log 2p N ), где p I вероятность того, что именно I –е сообщение выделено в наборе из N сообщений.Другая запись формулы Шеннона: I=-Задача. Пусть имеется строка текста, содержащая 1000 букв. Буквы встречаются в тексте: «о»-90 раз «р» -40 раз «Ф»- 2 раза «а»-200 раз. Какое количество информации несет буква в строке?Решение: I=-(0,09*log 2 0,09 + 0,04* log 2 0,04 + 0,002* log 2 0,002 + 0,2* log 2 0,2)= |

rpp.nashaucheba.ru

Формула Шеннона

В 1928 г. американский инженер Р. Хартли предложил научный подход к оценке сообщений. Предложенная им формула имела следующий вид:

I = log2K , Где К – количество равновероятных событий; I – количество бит в сообщении, такое, что любое из К событий произошло. Иногда формулу Хартли записывают так:

I = log2K = log2(1 / р) = – log2р, т. к. каждое из К событий имеет равновероятный исход р = 1 / К, то К = 1 / р.

Задача.

Шарик находится в одной из трех урн: А, В или С. Определить сколько бит информации содержит сообщение о том, что он находится в урне В.

Решение.

Такое сообщение содержит I = log23 = 1,585 бита информации.

Но не все ситуации имеют одинаковые вероятности реализации. Существует много таких ситуаций, у которых вероятности реализации различаются. Например, если бросают несимметричную монету или “правило бутерброда”.

“Однажды в детстве я уронил бутерброд. Глядя, как я виновато вытираю масляное пятно, оставшееся на полу, старший брат успокоил меня:

– не горюй, это сработал закон бутерброда.

– Что еще за закон такой? – спросил я.

– Закон, который гласит: “Бутерброд всегда падает маслом вниз”. Впрочем, это шутка, – продолжал брат.- Никакого закона нет. Прсто бутерброд действительно ведет себя довольно странно: большей частью масло оказывается внизу.

– Давай-ка еще пару раз уроним бутерброд, проверим, – предложил я. – Все равно ведь его придется выкидывать.

Проверили. Из десяти раз восемь бутерброд упал маслом вниз.

И тут я задумался: а можно ли заранее узнать, как сейчас упадет бутерброд маслом вниз или вверх?

Наши опыты прервала мать…” ( Отрывок из книги “Секрет великих полководцев”, В.Абчук).

В 1948 г. американский инженер и математик К Шеннон предложил формулу для вычисления количества информации для событий с различными вероятностями. Если I – количество информации, К – количество возможных событий, рi – вероятности отдельных событий, то количество информации для событий с различными вероятностями можно определить по формуле:

I = – Sum рilog2рi, где i принимает значения от 1 до К.

Формулу Хартли теперь можно рассматривать как частный случай формулу Шеннона:

I = – Sum 1 / К log2 (1 / К) = I = log2 К.

При равновероятных событиях получаемое количество информации максимально.

Задачи.1. Определить количество информации, получаемое при реализации одного из событий, если бросают а) несимметричную четырехгранную пирамидку; б) симметричную и однородную четырехгранную пирамидку. Решение. а) Будем бросать несимметричную четырехгранную пирамидку. Вероятность отдельных событий будет такова: р1 = 1 / 2, р2 = 1 / 4, р3 = 1 / 8, р4 = 1 / 8, тогда количество информации, получаемой после реализации одного из этих событий, рассчитывается по формуле: I = -(1 / 2 log21/2 + 1 / 4 log21/4 + 1 / 8 log21/8 + 1 / 8 log21/8) = 1 / 2 + 2 / 4 + + 3 / 8 + 3 / 8 = 14/8 = 1,75 (бит). б) Теперь рассчитаем количество информации, которое получится при бросании симметричной и однородной четырехгранной пирамидки: I = log24 = 2 (бит). 2. Вероятность перового события составляет 0,5, а второго и третьего 0,25. Какое количество информации мы получим после реализации одного из них? 3. Какое количество информации будет получено при игре в рулетку с 32-мя секторами?

Физиологи и психологи научились определять количество информации, которое человек может воспринимать при помощи органов чувств, удерживать в памяти и подвергать обработке. Информацию можно представлять в различных формах: звуковой, знаковой и др. рассмотренный выше способ определения количества информации, получаемое в сообщениях, которые уменьшают неопределенность наших знаний, рассматривает информацию с позиции ее содержания, новизны и понятности для человека. С этой точки зрения в опыте по бросанию кубика одинаковое количество информации содержится в сообщениях “два”, “вверх выпала грань, на которой две точки” и в зрительном образе упавшего кубика.

При передаче и хранении информации с помощью различных технических устройств информацию следует рассматривать как последовательность знаков (цифр, букв, кодов цветов точек изображения), не рассматривая ее содержание.

Считая, что алфавит (набор символов знаковой системы) – это событие, то появление одного из символов в сообщении можно рассматривать как одно из состояний события. Если появление символов равновероятно, то можно рассчитать, сколько бит информации несет каждый символ. Информационная емкость знаков определяется их количеством в алфавите. Чем из большего количества символов состоит алфавит, тем большее количество информации несет один знак. Полное число символов алфавита принято называть мощностью алфавита.

Молекулы ДНК (дезоксирибонуклеиновой кислоты) состоят из четырех различных составляющих (нуклеотидов), которые образуют генетический алфавит. Информационная емкость знака этого алфавита составляет:

4 = 2I, т.е. I = 2 бит.

Каждая буква русского алфавита (если считать, что е=е) несет информацию 5 бит (32 = 2I).

При таком подходе в результате сообщения о результате бросания кубика , получим различное количество информации, Чтобы его подсчитать, нужно умножить количество символов на количество информации, которое несет один символ.

Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на число знаков в сообщении.

studfiles.net

Вероятностный подход к измерению информации. Формула Шеннона

Вероятностный подход

Равновероятные событияФормула Шеннона

Формула ШеннонаВероятностный подход

Задача

Решение

Задача

Решение

Вероятностный подход

Задача

Решение

Задача 2

Домашнее задание

Дополнительная задача

Использованные источники:

|

rpp.nashaucheba.ru